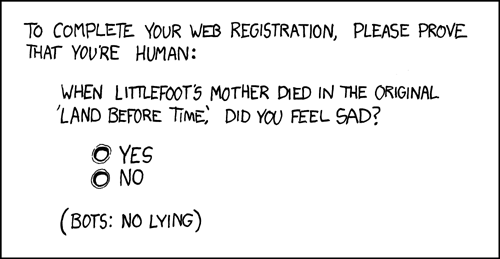

Loguję się przy każdej wizycie na mojej stronie i ustalam, czy gość jest człowiekiem. Przeszukałem internet i znalazłem wiele interesujących pomysłów, jak wykryć, czy odwiedzający jest człowiekiem.Jak wykryć, czy odwiedzający jest człowiekiem, a nie pająkiem?

- jeśli użytkownik jest zalogowany i przeszły CAPTCHA

- wykrywanie zdarzeń myszy

- wykrycie, czy użytkownik ma przeglądarkę [agenta użytkownika]

- wykrywające kliknięć myszką [jak pójdę na ten temat?]

Czy istnieją inne bezpieczne sposoby wykrywania, czy odwiedzający jest człowiekiem?

Zapytaj, ile ma nóżek. –

Niezły, Nick. Uwielbiam humor ... +1 – pixelbobby

- Merci, amigos! –